Im Rahmen der Anwendung sollte die Körper-Bewegung und die Mimik einer Person auf virtuelle 3D Figuren (Avatare) übertragen werden. Bei diesem System erfasst ein iPad die Bewegung des Körpers (Motion Capture) und ein vor dem Kopf angebrachtes iPhone die Mimik (Face-Tracking). Die Daten wurden in einem externen Apple Rechner mit ARKit weiter verarbeitet und auf die 3D Figuren (Avatare) in Echtzeit übertragen. Um den beiden Personen, die im Keyvisual des Kunden eingesetzt wurden möglichst nahe zu kommen orientierten wir uns an Bild-Material eines PhotoShootings, um die Figuren zu gestalten.

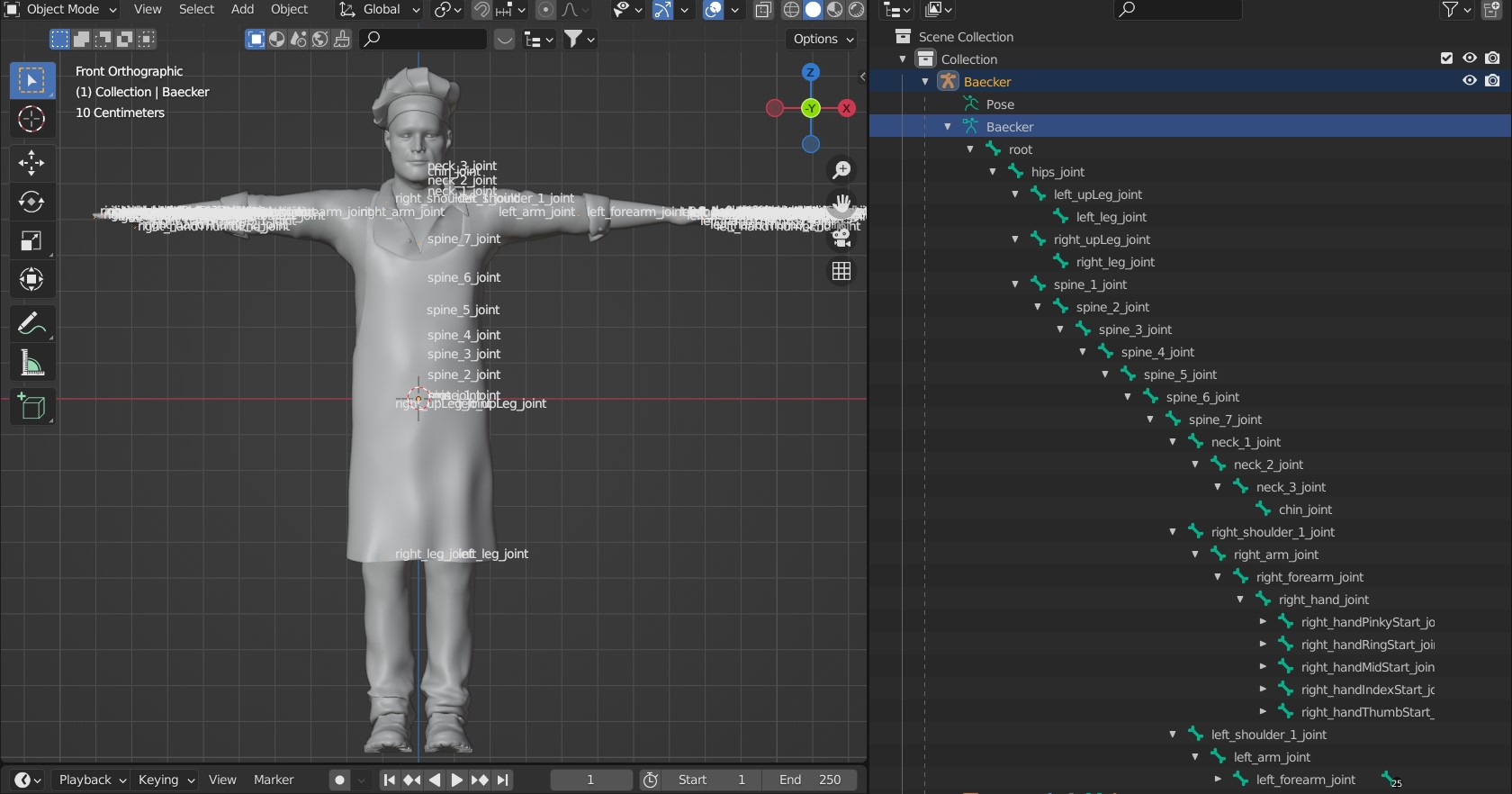

Im nächsten Schritt musste das für die Körperbewegung zuständige „Skelett“ der Figur nach von Apple definierten, speziellen Spezifikationen

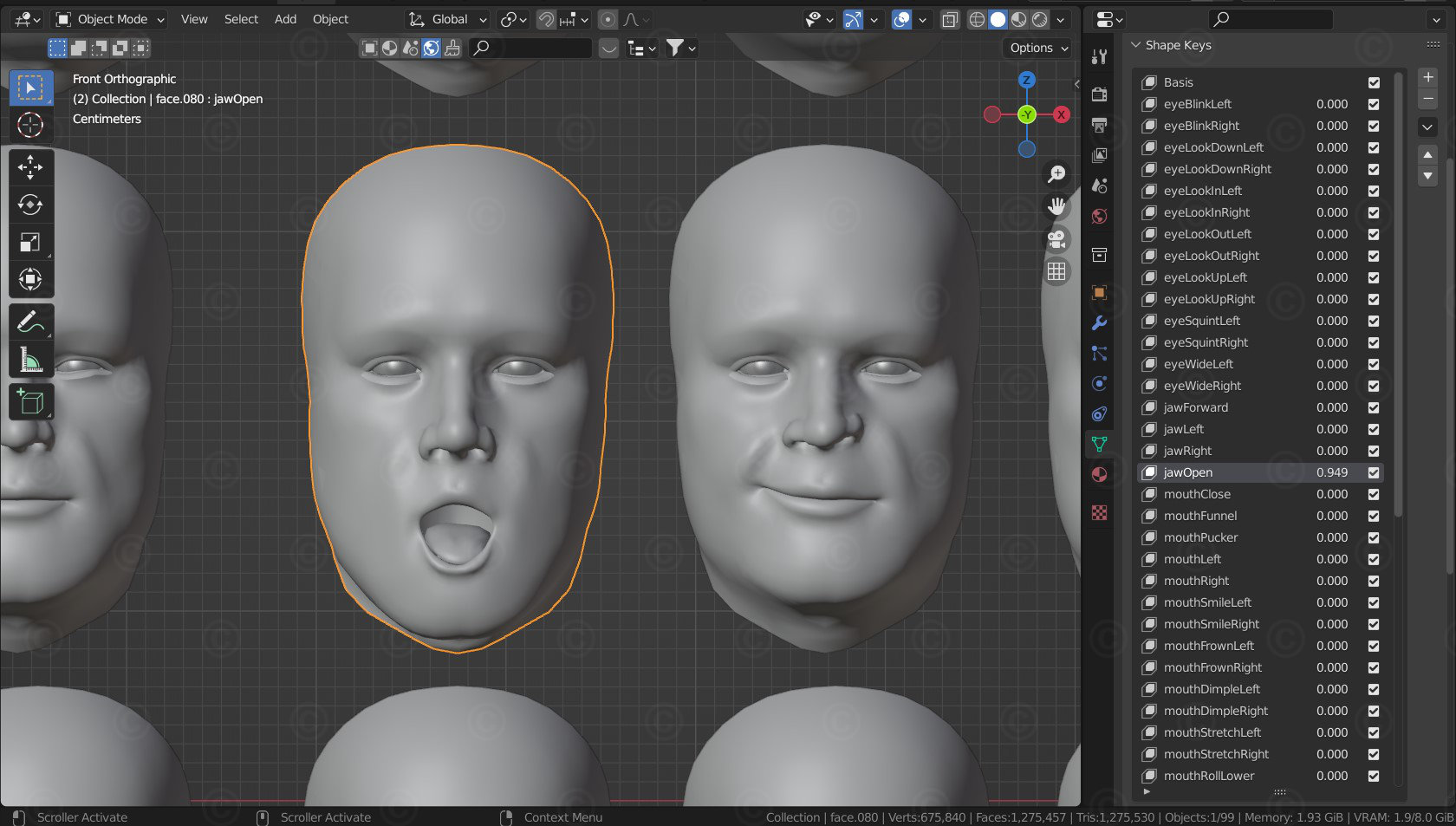

angelegt werden. Für die Mimik mussten ca. 50-60 verschiedene „Gesichtsausdrücke“ (eigentlich einzelne Bewegungen von Teilen des Gesichts wie linkes Auge geschlossen, Oberlippe hochziehen, linker Mundwinkel herunterziehen etc.)

angelegt werden. ARKit interpretiert die vom iPhone aufgenommen Videos mittels einer KI (eigentlich einem durch machine learning oder deep learning erstellten Programmteil) und bildete die Gesichtsausdrücke im Gesicht der virtuellen Figur nach. Da das System auch bei eigentlich einfachen Gesichtsausdrücken dutzende der Blendshapes miteinander mischte, war die Herausforderung diese so zu gestalten, dass das Endergebnis nicht verzerrte oder völlig überzeichnete Posen produzierte.

Projektdetails:

Umfang: 2 Figuren mit Bones-System und ca. 55 Blendshapes für das Gesicht

Einsatzgebiete: Anwendung zum Einsatz auf Kongressen

Technisches: Umsetzung per Apple ARKit und iPhone und iPad

Kunde / Auftraggeber: -NDA-

Die Nutzungsrechte der hier gezeigten Illustrationen liegen beim Auftraggeber, eine Verwendung ist nicht gestattet. Die Bilder sind mit Wasserzeichen geschützt.